Usability-Tests in der Praxis – ein Werkstattbericht des Projekts ROSI

ein Beitrag von Grischa Fraumann und Svantje Lilienthal

read this article in englishWie lässt sich evaluieren, ob eine neu entwickelte Anwendung gut nutzbar ist? Die Nutzenden direkt zu befragen ist eine nahe liegende Möglichkeit. Usability-Tests sind hierfür eine gute Methode.

Im Rahmen des Projekts ROSI (Referenzimplementierung für offene szientometrische Indikatoren) haben wir Usability-Tests genutzt, um unsere entwickelte Software-Anwendung zu testen. In diesem Blogpost möchten wir einen Einblick geben in unser Vorgehen und unsere Erfahrungen, um somit andere Projekte ermutigen, einen ähnlichen Ansatz zu verwenden. Wir stellen kurz unser Projekt vor, gehen dann auf den Ablauf der Usability-Tests ein und geben einige Empfehlungen, die auf unseren Erfahrungen aufbauen.

Das Projekt

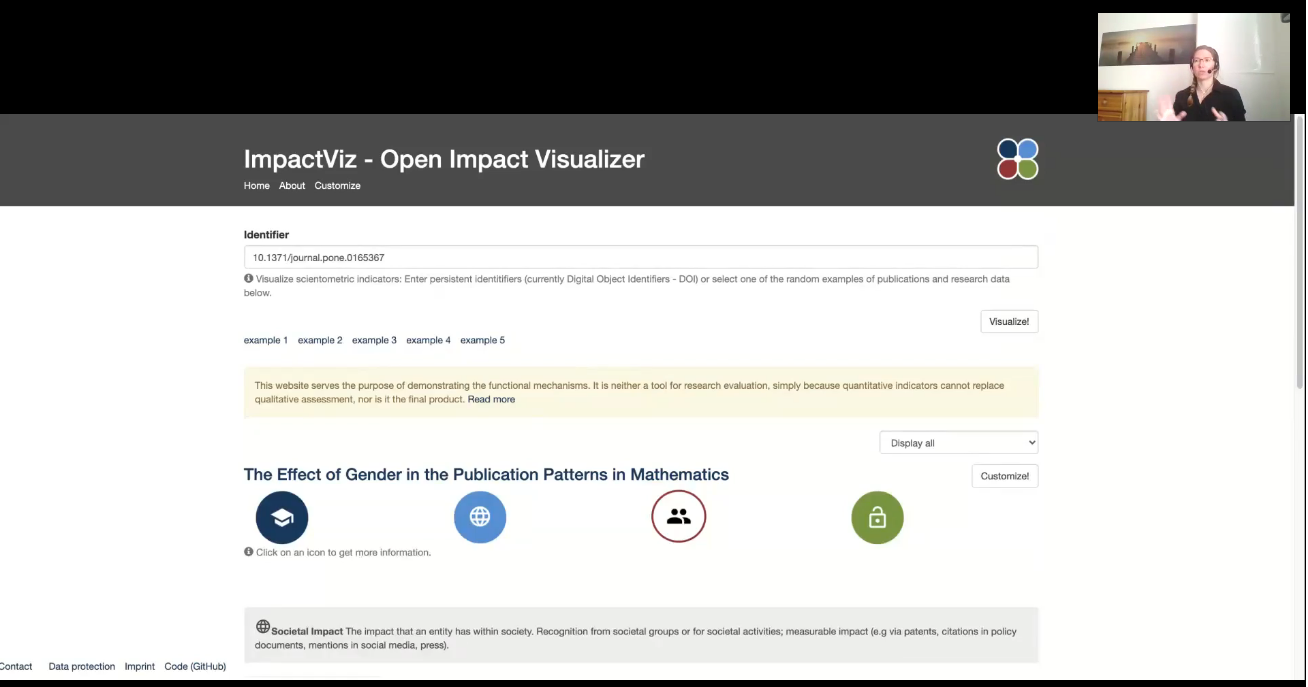

Das Projekt ROSI beschäftigt sich mit der nutzerzentrierten Entwicklung eines Prototyps für die anpassbare Darstellung offener szientometrischer Indikatoren (z. B. Zitationen oder Erwähnungen wissenschaftlicher Publikationen in Wikipedia). Weitere Informationen zur Motivation des Projekts, sowie zum erstellten Verzeichnis von szientometrischen Datenquellen sind in eigenen Blogposts zu finden. Dafür wurden potenzielle Nutzende in Interviews und Workshops befragt und parallel eine Webanwendung (Blogpost zum Prototypen) entwickelt. Diese iterative Herangehensweise ermöglichte mehrere Versionen, in denen die Software ständig durch Nutzerfeedback verbessert werden konnte. Dies erlaubt eine besondere Berücksichtigung der Nutzerbedürfnisse und eine zielgenaue Entwicklung der Software. Ein wichtiger Baustein hierbei sind auch die erwähnten Usability-Tests. Hierbei testen Nutzende die entwickelte Anwendung unter Aufsicht und sprechen laut ihre Gedanken beim Testen der Software aus (sogenanntes Think Aloud Testing).

Ablauf

Insgesamt haben wir vier Online-Interviews mit verschiedenen Teilnehmenden geplant – eines davon ein Testinterview – um vorab die Technik und die Abläufe zu testen. Nachfolgend beschreiben wir kurz die einzelnen Phasen: Planung, Durchführung und Auswertung.

Planung

Durch die vorab durchgeführten Interviews und Workshops im Rahmen des Projektes konnten wir auf eine große Menge an potentiellen Teilnehmenden zugreifen. Zudem konnten wir von den Erfahrungen aus anderen Projekten der TIB profitieren, da wir z. B. an der Evaluation des Europeana Enhanced Unified Media Player teilnehmen durften. Wir haben die Interview-Fragen und Aufgaben vorab definiert und nach dem Testinterview noch einmal angepasst. Daraufhin wurden die Teilnehmenden persönlich per E-Mail eingeladen.

Durchführung

Die Online-Interviews wurden von uns zu zweit durchgeführt und die Aufgaben haben wir aufgeteilt: Moderation und Mitschreiben (teilweise auch im Wechsel). Die Interviews dauerten in der Regel 60 Minuten, wobei einige etwas kürzer waren, je nachdem wie die Teilnehmenden die offenen Fragen beantworteten. Wir haben das Tool WebEx verwendet und die Teilnehmenden gebeten, in der Anwendung ihren Bildschirm zu teilen, sowie auch Ihre Kamera einzuschalten.

Zu Beginn des Interviews wurden das Projekt und die Ziele des Tests kurz vorgestellt. Am Anfang hatten die Nutzenden Zeit, die Anwendung selbst zu testen. Anschließend wurden einige konkrete Aufgaben gestellt. Die Nutzenden sollten z. B. herausfinden, wie sie die Informationen darüber finden können, welche Datenquelle einem bestimmten Indikator zugeordnet ist. Abschließend wurden einige offene Fragen gestellt, um die Meinung der Nutzenden zu erfragen, z. B. ob sie weitere Verbesserungsvorschläge zur Visualisierung haben.

Auswertung

Die verschiedenen Funktionen des Prototyps konnten die Nutzenden weitestgehend problemlos testen, einige Unklarheiten traten nur bei einem der Anwendungsfälle auf. Ein wichtiges weiteres Feedback war der Wunsch nach umfassenden Erklärungen zu den dargestellten Inhalten und Funktionen. Der freie Test zu Beginn erleichterte den Nutzenden den Einstieg in das Interview sehr und ermöglichte teilweise die leichtere Erledigung der gestellten Aufgaben.

Lessons Learned und Fazit

Was können wir anderen Projekten mit auf den Weg geben?

- Es lohnt sich vorab als Teilnehmende an ähnlichen Evaluationen teilzunehmen, um die eigenen Usability-Tests zu verbessern.

- Der Ablauf und die gestellten Fragen und Aufgaben sollten vorab einmal in einem Testinterview getestet werden. Hierbei lohnt es sich auch besonders, die Technik sehr gründlich zu prüfen.

- Es ist einfacher, die Aufgaben (Moderation und Mitschrift) während des Interviews zwischen zwei Personen aufzuteilen.

- Nutzende sind sehr unterschiedlich und haben z. B. verschiedene technische Kenntnisstände. Deshalb ist es von Vorteil zu wissen, wie erfahren die Nutzenden sind. Bei Bedarf können die Nutzenden auch Hilfestellung bei der Lösung der Aufgaben erhalten.

Eine Evaluation vor Ort hätte eventuell mehr Zeit in Anspruch genommen. Insgesamt waren die Ergebnisse der Online-Interviews sehr hilfreich und der Aufwand angemessen.

I am a member of the IBID research group (Information Behavior and Interaction Design) at the Department of Communication. Before joining the University of Copenhagen, I worked as a Research Assistant at TIB Leibniz Information Centre for Science and Technology. I was also a Visiting Researcher at the Centre for Science and Technology Studies (CWTS), Leiden University.